Harnessing The ML Backends for Efficient Labeling in Label Studio

Introduction

Open source data labeling platform Label Studio에 Label Studio ML Backend의 도입으로 machine learning model을 통합하고 labeling 작업을 위한 자동화된 예측을 제공할 수 있다.

이를 통해 labeling process를 가속화하고 일관성과 정확성을 향상시킬 수 있으며 실시간으로 모델의 성능을 평가하고 빠르게 반복함으로써 model을 지속적으로 개선할 수 있다.

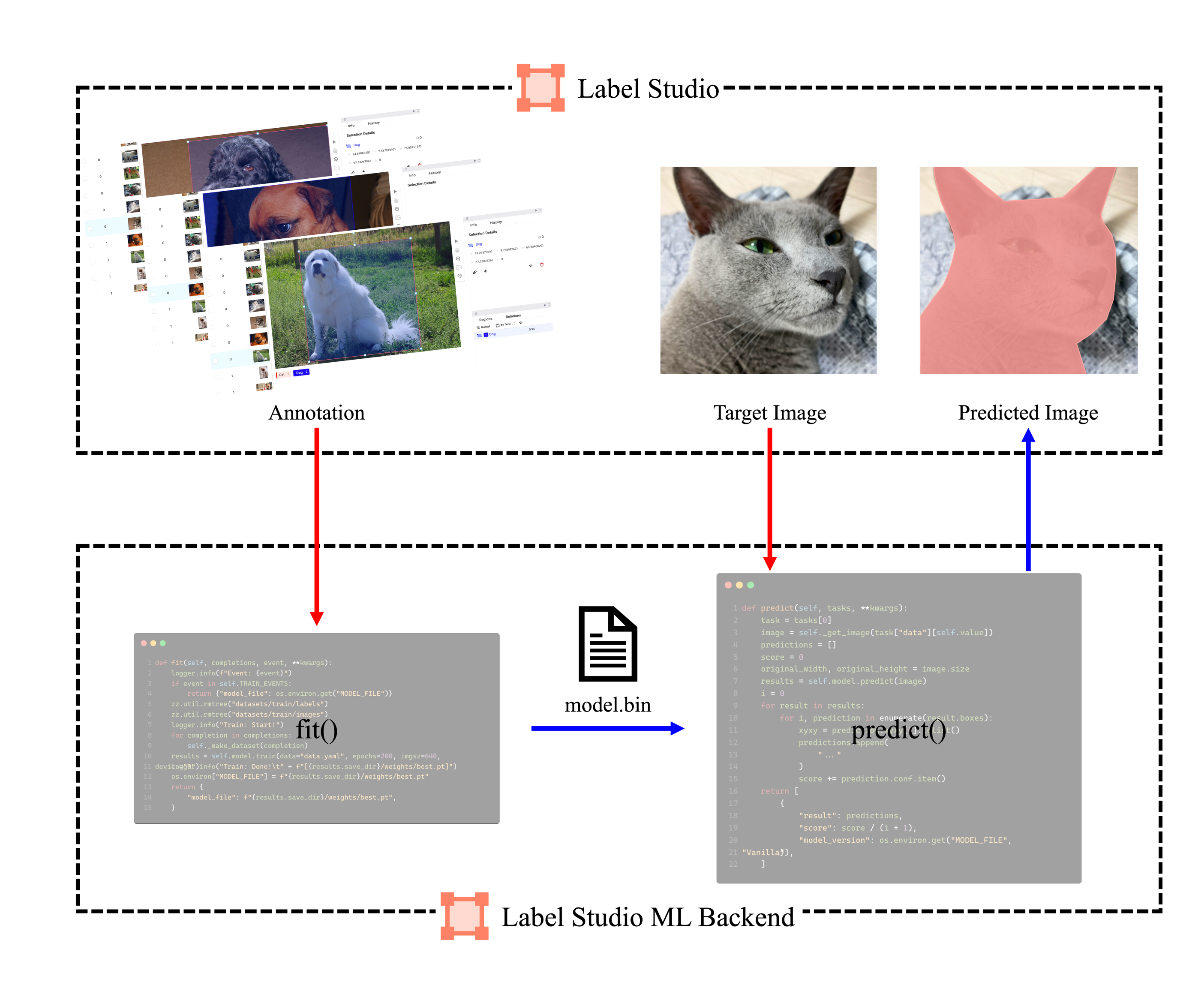

Label Studio와 Label Studio ML Backend의 작동 방식은 아래와 같이 구성된다.

predict(): 입력된 data에 대해 model의 출력을 Label Studio format으로 변경 후 UI에 제공fit(): Label Studio 내 annotation이 완료된 data를 학습하고 load